Estudo desenvolve modelo de IA que identifica sintomas de AVC a partir de vídeos do rosto

O acidente vascular cerebral (AVC) — popularmente chamado de derrame cerebral — é uma das doenças que mais mata no Brasil. Somente em 2023, foram mais de 110 mil mortes no país, aproximadamente uma a cada cinco minutos, segundo a Sociedade Brasileira de AVC (SBAVC). A identificação precoce dos sintomas pode ser crucial para reduzir o risco de morte e limitar os danos no tecido cerebral. Especialistas afirmam que, com uma resposta médica eficaz em até três horas após o episódio é possível reverter a maior parte dos danos.

O atendimento inicial a este paciente, entretanto, nem sempre é realizado por indivíduos capazes de identificar o AVC, e a literatura científica mostra que mesmo socorristas têm dificuldades em identificar seus sinais mais sutis. Cientes desse cenário, um grupo de pesquisadores da Faculdade de Ciências da Unesp, no campus de Bauru, e da Faculdade de Engenharia do Instituto Real de Tecnologia de Melbourne (RMIT), na Austrália, desenvolveu uma ferramenta piloto que se mostrou eficaz em identificar se uma pessoa teve ou está prestes a ter um AVC com base em suas expressões faciais.

O AVC ocorre quando há uma interrupção súbita do fluxo sanguíneo no cérebro, impedindo que o órgão receba oxigênio e nutrientes. Isso pode causar danos permanentes às células na área afetada e, em alguns casos, comprometer a capacidade do paciente em executar tarefas tidas como cotidianas pelo resto da vida. Em geral, indivíduos prestes a ter um AVC apresentam sinais faciais bastante sutis, como dificuldade para levantar um dos lados da boca ao sorrir, perda parcial ou total do controle dos movimentos faciais e dificuldade para falar. Saber reconhecer esses sintomas permite que o paciente seja levado mais rapidamente ao hospital e receba tratamentos adequados para restaurar funções, movimentos e a fala.

Codificando movimentos do rosto

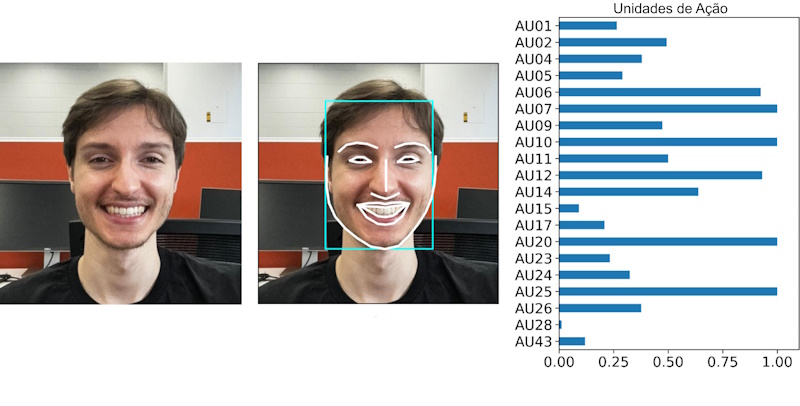

A tecnologia desenvolvida pelos pesquisadores da Unesp e do RMIT utiliza algoritmos de inteligência artificial (IA) para escanear o rosto de pacientes e determinar se ele teve ou está tendo um acidente vascular. A ferramenta analisa movimentos faciais específicos, categorizados na década de 1970 pelos cientistas norte-americanos Paul Ekman e Wallace Friesen, que desenvolveram um sistema de mensuração científica dos movimentos faciais humanos chamado FACS (ou Facial Action Coding System, em inglês).

O FACS classifica os movimentos faciais com base na contração e no relaxamento dos músculos da face. Cada componente observável desses movimentos corresponde a uma Unidade de Ação, e cada Unidade de Ação corresponde ao movimento de um ou mais músculos faciais. A combinação de diferentes unidades representa diferentes expressões, como levantar as sobrancelhas, sorrir com os lábios ou fingir soprar uma vela.

Os pesquisadores da Unesp e da Austrália codificaram as Unidades de Ação do rosto de onze indivíduos saudáveis e de 14 que tinham sofrido um AVC com base em vídeos de pacientes reais disponíveis em um banco de dados da Universidade de Toronto, no Canadá. Em seguida, usaram essas informações para treinar o algoritmo a conseguir diferenciar as Unidades de Ação de indivíduos saudáveis daqueles que acometidos pelo AVC. “Em geral, os músculos faciais das pessoas que tiveram um acidente vascular se tornam unilaterais, de modo que um lado da face se comporta de maneira diferente do outro”, diz o cientista da computação João Paulo Papa, da Faculdade de Ciências da Unesp, um dos autores de um artigo publicado em junho na revista Computer Methods and Programs in Biomedicine apresentando os resultados do estudo piloto com a nova ferramenta.

Os cientistas então colocam o sistema para analisar os vídeos novamente. Os resultados indicam que o modelo de IA identificou corretamente 82% dos casos. “A principal vantagem do uso dessa estratégia é que ela fornece uma avaliação baseada em alterações clinicamente observáveis”, destaca Papa. Embora os resultados sejam promissores, os autores afirmam que o modelo não pretende substituir os testes de diagnóstico clínico atualmente usados para diagnosticar a doença. “Nossa intenção é ajudar na identificação precoce dos sintomas e agilizar o atendimento médico”, afirma Papa.

Refinar a ferramenta e torná-la popular

Os pesquisadores agora trabalham para transformar a ferramenta em um aplicativo para smartphones. “Queremos que ele seja o mais simples possível”, diz o cientista da computação. “A ideia é que o usuário aponte a câmera para o próprio rosto ou para o rosto de alguém e grave um vídeo falando algumas frases ou fazendo movimentos faciais específicos”, ele explica. Os autores também esperam que, no futuro, a ferramenta possa ser usada pelos profissionais de saúde na emergência de hospitais, de modo a reduzir o risco de erro de diagnósticos e otimizar o atendimento e tratamento dos pacientes.

Estudos estimam que até 13% dos casos de AVC não sejam detectados nos serviços de urgência porque enfermeiros e socorristas têm dificuldade para identificar sinais sutis ligados ao problema. “Os socorristas poderiam usar a ferramenta na casa do paciente, determinar se ele está tendo um AVC e informar o hospital antes de a ambulância chegar.”

No entanto, para que isso aconteça será preciso superar algumas barreiras. A primeira, de ordem científica, é conseguir adaptar a ferramenta à capacidade de memória e processamento dos smartphones atuais. O segundo, de caráter comercial, é conseguir fazer com que o produto chegue ao mercado e ganhe escala. “Estamos tentando fazer parcerias com hospitais para validar o modelo em situações reais”, diz Papa. “A colaboração com prestadores de cuidados de saúde será crucial para integrar nossa aplicação aos protocolos de resposta a emergências existentes, fornecendo aos paramédicos um meio eficaz de detecção precoce de AVC.”

Os autores pretendem continuar a otimizar o modelo. A expectativa é aumentar sua precisão à medida que incorporam registros de mais pacientes. “Precisamos refinar e testar o modelo em indivíduos de outras raças, etnias, idade e gênero para torná-lo mais abrangente”, afirma o pesquisador. Eles também querem ampliar o alcance da ferramenta, de modo que ela seja capaz de identificar sintomas e até mesmo ajudar a monitorar a progressão de doenças neurodegenerativas como Parkinson, Alzheimer e Esclerose Lateral Amiotrófica (ELA), enfermidades que também marcadas por algum tipo de paralisia facial e que podem começar a se desenvolver até 20 anos antes de sua manifestação clínica. “Nesse caso, será preciso cruzar as análises das expressões faciais com dados clínicos do paciente, para uma indicação mais precisa do problema que ele tem.”